9 Optimization tippek Honlap kraulingovogo költségvetés

Mit társítani a kifejezés „kereső optimalizálás”? Sokan azonnal eszünkbe jut egy listát a rangsorolási tényezők, mint például a megfelelő címkéket, releváns kulcsszavakat, tiszta sitemap és minőségi tartalom. De van egy másik fontos szempont - kraulingovy költségvetést.

Sok SEO-szakemberek nem figyelni ezt a tényezőt, nem egészen a megértés a pontot. Azonban kraulingovy költségvetés és optimalizálni kell. Ez lesz szó a cikkben.

Mi a költségvetés kraulingovy oldalon?

Internetes szolgáltatások és a keresőmotorok speciális robot pókok feltérképezi az internetet, és add hozzá az index. A keresőrobotok is meghatározhat olyan oldalakra mutató linkeket, és mozgassa őket, hogy átvizsgálja a másik oldalon.

Között a kereső robotok jelennek Googlebot, Bingbot és mások. Sok SEO-eszközök is használhatja pókok, hogy információkat gyűjtsön.

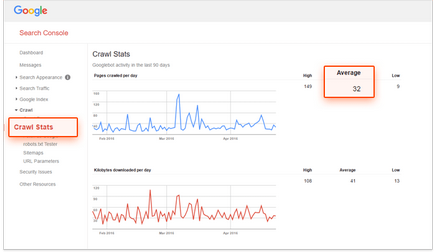

A „kraulingovy költségvetés” kifejezés az oldalak számát, hogy a bejáró lehet megkerülni egy adott időszakban. Ha a Googlebot beolvassa 32 oldal naponta, a hónap kraulingovy költségvetés lesz 960 oldal.

Határozzuk meg a hozzávetőleges költségvetés kraulingovy oldalon, akkor használja, mint a Google Search Console és a Bing Webmaster Tools. Ehhez nyissa meg a jelentést, „Crawl Stats”, és hogy mennyit, átlagosan beolvasott oldalak naponta.

Optimization kraulingovogo költségvetési = SEO?

Igen és nem. Bár mindkét optimalizálás célja, hogy oldalakat jobban látható, hogy a keresőmotorok, ezek más jellegű.

SEO nagyobb hangsúlyt helyez a felhasználói élmény és a webhely indexelése optimalizálás összpontosító kereső robotokat. A szavak az alapító KISSmetrics Neil Patel:

«SEO összpontosít folyamatok optimalizálása felhasználói kéréseket. Optimalizált Googlebot - miként a Google kereső robot hozzáférést nyer az oldalon. "

Hogyan lehet optimalizálni a költségvetési kraulingovy

Ha nem szeretné, hogy az oldal jelenik meg a találatok között, meg kell tagadni a hozzáférést meg a .htaccess és robots.txt. Azonban a Google szerint. Egy disallow a robots.txt fájlban nem elég:

„Tiltása irányelv nem biztosítja hiányában az oldalt a keresési eredmények között. A Google továbbra is kutatnak, figyelembe véve az érintett harmadik féltől származó információ, például a bejövő linkek. Ha azt szeretnénk, hogy szigorúan tilos indexelni az oldalt, akkor a robotok meta tag egy noindex érték vagy HTTP-fejléc X-Robots-Tag. Ebben az esetben nem blokkolja a hozzáférést az oldal robots.txt, mert a Google robotjai olvasni, hogy megtalálja a címkét, és végre az irányelvet. "

A robotok meta tag egy NOINDEX attribútummal. Helyezzük a részben

oldal:X-Robots-Tag. Cím X-Robots-Tag elem lehet a HTTP-cím egy adott URL-t. NOINDEX irányelv, hogy lehet használni a meta robotok, és szintén alkalmazható X-Robots-Tag:

Most a Google képes kezelni a legtöbb típusú multimédia fájlokat, de nem az összes keresők tud. Ezért ezeket a fájlokat kell óvatosan alkalmazható. Ez indokolt lehet, és egyáltalán nekik akár azokat az oldalakat, hogy szeretné látni a keresési eredmények között.

A lista az összes fájltípus, hogy a Google index, megtalálható itt.

Az a kérdés, hogy a törött linkeket a rangsorban, a Google szóvivője Dzhon Myuller befolyása mondta egyszer. „Nem fontos, hogy először a felhasználók számára.”

Ha a szavait - azonban ez az egyik alapvető különbség SEO és optimalizálja a keresőmotorok. Törött linkek nem játszik jelentős szerepet a rangsorban, akkor is, ha nehéz Googlebot indexelés és rangsorolás az oldalon.

Azonban a Google algoritmusok javult minden évben, és minden, ami hatással van a felületen, akkor végső soron befolyásolja a keresési eredményeket.

Keresés robotok kezeli az URL dinamikus, ami ugyanazon az oldalon, mint a különböző oldalakon. Ez azt jelenti, hogy ezen a módon nem lehet felhasználni kraulingovy költségvetést. Azt is ellenőrzik a paramétereket az URL a Google Search Console. Ehhez menj a „Beállítások URL» részén. Itt adhatod meg a Google, hogyan kell kezelni egy URL-t, amelyek bizonyos paraméterek. Így lehetővé válik, hogy megszüntesse ismétlődő tartalmat az oldalon.

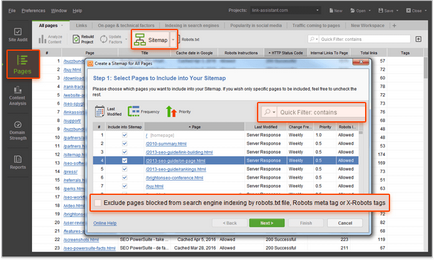

XML Sitemap fájlt, és segít a felhasználóknak és a kereső pókok, tartalom szervezésének és megkönnyíti a keresést. Tartsa sitemap naprakész és tisztítsa meg mindent, ami károsíthatja a használhatóságát a forrás: az oldalak, hogy visszatérjen a 4xx hibát, felesleges átirányításokat, nem kanonikus URL-t és blokkolja a indexelés.

Ahhoz, hogy egy site map érdekében, akkor használja az eszközt honlap ellenőr. Az XML Sitemap Generator hozhat létre egy új site map, hogy hiányozni fog a lezárt indexelt oldalak. A helyszíni ellenőrzés lesz könnyű megtalálni, visszatérő 4xx hibaoldalakra 301 és 302 átirányításokat és a nem gyűjtő oldalak.

RSS-feed már régóta tekinthető jó módja, hogy növelje a felhasználók bevonása. Azt is Többek között a források, amelyek a leggyakrabban látogatott Googlebot által. Ha a webhely frissül, ezt az információt, hogy a takarmány-író a Google, így jól indexelt.

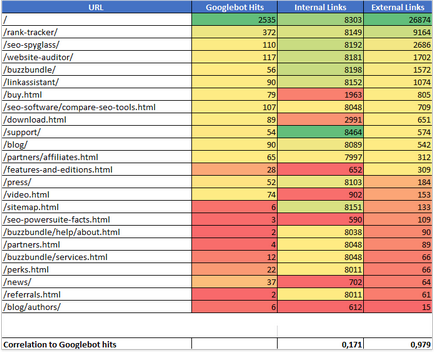

Egy nemrégiben kísérletet Johan Kutarnyuka azt mutatta, hogy a bejövő linkek korrelálnak a látogatók száma, hogy a webhely a keresőmotor pókok.

A kísérlet során a Kutarnyuk azonosított valamennyi belső és külső linkek mutatnak az egyes oldalak 11 különböző helyszínen. Ezután elemezte a statisztikák minden oldal, és összehasonlították az eredményeket. Az alábbiakban - a kapott adatok egyik oldalak:

erős korrelációt találtak a kísérletben (0,978) között a látogatók száma a honlapon keresés robot száma és a külső linkek.

Kutarnyuka kísérlet kimutatta, hogy a belső referencia nem befolyásolja jelentősen a felvételi sebessége. Ez azonban nem jelenti azt, hogy figyelmen kívül kell hagyni. Átgondolt szerkezet a honlap lehetővé teszi a keresőrobotok számára, hogy olyan tartalmat talál a kerékpáros költségvetési kraulingovy kárba.

Logikai és jól átgondolt szerkezet belső kapcsolatok is javítja a felhasználói élményt - különösen, ha a látogató eljut olyan hely a helyszínen három kattintással. Könnyebb a tartalomhoz való hozzáférést biztosítja, hogy a felhasználók töltik a helyszínen már nem. Ennek eredményeként lehet javítani a rangsorban.

következtetés

Optimization kraulingovogo helyszínen költségvetés - fontos része a SEO-szakemberek, és meg kell csinálni. Ha megkönnyítése Google indexelő az erőforrás, robot pókok gyakran látogatják, és a frissítés jelenik meg a keresési eredmények között. Azt is javítja a tapasztalat kölcsönhatás a felhasználók a honlap, ami végső soron növeli a pozícióját a keresést.